Professional Documents

Culture Documents

נוסחאון דאטה

נוסחאון דאטה

Uploaded by

DanielCopyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

נוסחאון דאטה

נוסחאון דאטה

Uploaded by

DanielCopyright:

Available Formats

Introduction

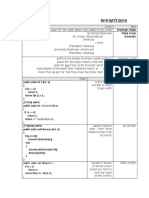

ILOCלפי מספר עמודה ]]( df.iloc[10:20,[6, 1, 3לא כולל עמודה אחרונה) df['total'] = Series

LOCלפי שם עמודה ]’( df.loc[1:3,'cut':'clarityכולל עמודה אחרונה) df[['total']] = DF

)matplotlib( Data visualization

מדדי מרכז: - Unimodal distributionנקודת מקסימום אחת

חציון – עמיד יותר בפני ערכים קיצוניים, – Bimodal distributionמספר נקודות מקסימום

מרכזי יותר – Pie chart,3d chartקשה לעשות השוואות

ממוצע – יותר מושפע –Line chartמראה השוואה של שני משתנים רציפים

– Histogramמתארת את הצורה של הדאטה ,מתארת שכיחויות למידע רציף.

– Bar chartמראה את הצורה של הדאטה ,למידע קטגוריאלי .מתארת ערכים קטגוריאליים ,מספר מופעים של דבר מסוים.

באמצעות הצרה של ה binsניתן לראות יותר פרטים על הדאטה.

– Scatter Plotמראה יחס בין שני משתנים רציפים.

– Stacked barבדיקת יחס/קשר בין שני משתנים קטגוריאליים; פרופורציות של מידע.

)Take the time to examine your data before modeling( Data exploration

סטיית תקן גבוהה – התפלגות מפוזרת

:Display price values higher than 10,000# סטיית תקן נמוכה – קרוב לממוצע

]df_sub_HighPrice = df[df['price'] > 10000 Outliers < Q3 + 1.5*IQR | Q1 - 1.5*IQR < Outliers

כדי לחקור עמודה נומרית ,צריך לדעת סטיית תקן ,ממוצע ,חציון וטווח.

(Learn how to fix data quality problems - missing values, data transformation( Data preprocessing

כולל טיפול בערכים חסרים ,שכר שלילי ,ערכים לא הגיוניים (גיל של ] .)370נתחיל עם describeו [shape

)( – Isnullמחזיר Trueאם הערך ריק באותה המשבצת | .מחיקת ערכים חסרים (אם כל השורה ריקה) df = df.dropna() -

החלפת ערכים חסרים בעמודות קטגוריאליות df['employed']=df['employed'].replace(to_replace=np.nan, value='Retired') -

)df['income']=df['income'].mask(df['income']<0,np.nan

)' – df=df.dropna(how='allמחיקה רק אם כל השורה ריקה .interpolate = linear | .הופך את 4,null,1,2ל 1,2,3,4

) df.dropna(subset=['housing.type', 'is.employed'], inplace=Trueתזרוק לי שורות אם יש להם ערכים חסרים בעמודות המסוימות.

- Data Transformationמיפוי קבוצת ערכים של משתנה נתון לקבוצה חדשה של ערכי החלפה] .ערך טיפוסי = [IQR

- Discretizationמעבר ממשתנה רציף לקטגוריאלי (הורדת האפקט של ה ,outliersהורדת כמויות של מידע לצורך הבנה טובה יותר)

- Normalizationלנרמל את כל הערכים שיהיו באותו היחס

.zscore() perform normalization on all numeric variables in the data

(ממוצע , 0סטיית תקן .)1ערכים מנורמלים נחשבים כטיפוסיים אם הם בין 1-ל.1

)]'df['ageZ']=stats.zscore(df['age

transformation for skewed distributions to look more normal and symmetric - Log Transformation

]'( df['logincome']=np.log10(df['logincomeערכי מינימום )1

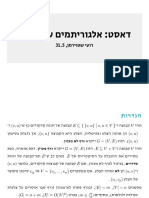

supervised, classification – Decision tree

בתוך – supervised

בינארי (האלגוריתם מסווג לשני קטגוריות) -

מולטיקלאס (האלגוריתם מסווג ליותר משני קטגוריות) -

רגרסיה (האלגוריתם חוזה ערכים רציפים) -

– Classificationאנחנו רוצים לחזות משהו(קלאס ,לייבל) ,הוא קטגוריאלי ,וגם התשובה קטגוריאלית(.חתול/כלב)

צריך למצוא את הערכים האופטימליים וההומוגניים אשר יהיו צמתי ההחלטה בעץ לצורך ניבוי המידע.

כלומר ,לבצע סינון של עצמים עפי עמודות שיניבו לנו ערכים לא שווים )100-0( ,או ( )90-10ולא ( )50-50כדי שנגלה דפוס מסוים.

– Gini Indexמודד את רמת הטוהר של המידע ,בודק מהו הפיצ'ר האידיאלי לסינון המידע (צריך שיהיה נמוך יותר). o

]הומוגניות[

– Entropyמדד לרמת האקראיות של המידע. o

– Misclassification errorבודק לכמה תצפיות הניבוי יהיה שגוי; מדד לאיכות הפיצול. o

יתרונות :מהיר ,לא מתייחס לפיצ'רים לא משמעותיים,

יעיל ,לוגי.

]ימינה = ,falseשמאל = true

חסרונות :נטייה ל ,overfitted-שינויים במידע יכולים = classסוג הרוב באותו העלה

לשנות את התוצאות ,נטייה לפיצולים על פיצ'רים בעלי ככל שהצבע יותר כהה = יותר הומוגני

מס' קטגוריות. מדד Giniנמוך יותר = טוב יותר (מדד לאי שוויון)[

במידה ולא נגביל את העץ ,הסיכוי ל Overfittingיגדל וגם זמן העיבוד .ניתן להגביל את העומק ,את מינימום דגימות בעלה ,אחוז הומוגניות בעלה

ומקסימום עלים .מחלקים לקבוצות קטנות עד שניתן לסווג את התצפית .לא חייב לנרמל בעץ.

– Pruningקיצוץ ענפים בעץ שלא רלוונטים /לא משפיעים כלכך.

– LabelEncoderהפיכת קטגורי למספרים .נשתמש רק ב labelEncoderבהמרה של קטגורי לנומרי.

= Xכל הקטגוריאלים המומרים והעמודות הנומריות הרגילות = Y ,עמודת הטרגט

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.30, random_state=RSEED) - data separating

cm_test = pd. crosstab(y_test, y_pred_test, colnames=['pred'], margins=True) - confusion

Classification model validation

- Validationלהבטיח שהמודל יעבוד בעולם האמיתי כמו שהוא עובד ב testingאצלנו.

– Trueמשמע הניבוי נכון

אם התוצאה הומוגנית – accuracyמדד טוב מספיק

בפני עצמו.

– False negativeהכי חמור •

– Accuracyמספר הפריטים שסווגו נכון מבין כל הפריטים.

accuracyשל 99אחוז – לא הגיוני .לא מספיק רק accuracyכדי לבדוק אמינות של מודל.

- Recallמהו שיעור ה"חיוביים"

שהמודל מזהה נכון מתוך אלה באמת חיוביים? True Positive

מודל מתאים כאשר יש הטיה בנתונים –

לדוגמה :כמה נשים חוות סיבוכים בלידה? כ 1%-מהאוכלוסייה.

לדוג' :כמה תמונות של חתול חזיתי נכון מתוך כל החתולים?

– Precisionאיזה שיעור מהתחזיות שלי בנוגע ל"חיוביים" נכונות?

לדוג' :כמה תמונות הן אכן של חתול מתוך אלה שחזיתי שהן חתול?

צריך recallגבוהה למקרים רגישים .אכפת לי מהניבויים השליליים.

לדוגמה ,חיזוי מחלה או חיזוי טרוריסטים .זה בסדר אם גידול שאינו מסוכן מסומן מסוכן,

אך אין לסמן גידול מסוכן כבלתי מסוכן.

באופן דומה ,אנו זקוקים Precisionגבוה במקומות כגון מנועי המל צות ,זיהוי דואר זבל וכו' .שבהם לא אכפת לך מהניבויים השליליים אלא

מתמקדים יותר בתוצאות חיוביות אמיתיות וחיוביות שגויות .זה בסדר אם דואר זבל נכנס לתיקיית הדואר הנכנס ,אבל דואר חשוב באמת לא

אמור להיכנס לתיקיית הספאם.

- Overfittingאם למודל שלנו יש אחוזי דיוק גבוהים ב trainingאבל אחוזי דיוק נמוכים ב testאז המודל נקרא ( .overfittingניתן לזהות אם

שלושת המדדים מאוד גבוהים ב )training

צריך לשאוף תמיד לאמצע ,בין underfittingל ) ,overfitting (appropriate fittingלחלק את הקבוצות לכמה שיותר הומוגניות.

– Underfittingכללי מדי ,לא מפריד את ה labelsכמו שצריך.

באמצעות הגבלות ניתן להגיע ל( appropriate fittingהגדלת גודל העץ)

– Reverse_transformלהציג את השמות המקוריים בעץ החלטה.

– Knn Classificationמודל שבודק משתנה לפי השכנים שלו (supervised )classification

מודל שבודק משתנה עפ"י השכנים שלו = K .מספר השכנים (בד"כ אי זוגי כדי להימנע משוויון).

אנחנו בוחרים את ה .Kיש עמודת מטרה.

)classifier = KNeighborsClassifier(n_neighbors=k

נחשב את השכנים לפי נוסחת המרחק] .רגיש לחריגים ב [multiclass

)classifier.fit(X_train_z, y_train הפלט של המודל הוא קלאס.

חשוב לנרמל את המידע .פיצול המידע ל trainו .test

חשוב ש kיהיה מספר אי זוגי כדי שלא יהיה מצב שיש שני קלאסים שכנים עם אותה כמות.

עדיף לחשב עפי k=sqrt(N)/2

כלומר )k=int(math.sqrt(X_train.shape[0]/2 מרחק בין שני נקודות :

השיטה הכי טובה היא לבדוק כמה שיותר kולבדוק למי Kקטן – חשוף לרעש ,למקרים חריגים (אבל זמן ריצה יעיל יותר) ]אולי [OVERFIT

יש את הביצועים הכי טובים Kגדול – קלאס אחד יכול להיות דומיננטי על השני (זמן ריצה גבוה יותר) ]אולי [UNDER

(עפי הגרף – לוקחים את ה kהראשון מהרצף הכי גבוה) נמדד עפי ()accuracy ,recall ,precision

בודקים recall ,precisionעבור כל קלאס בנפרד.

– Logistic Regressionלא קשר לרגרסיה +לינאריתregression ,supervised .

פונקציית :S CURVE

ממדלת את הסיכויים של אירוע אחד מתוך שניים(אמת או שקר -סיווג בינארי)

מודל סטטיסטי שחוזה הסתברות (אחוז בין 0ל )1-לאירוע אחד מתוך שתי חלופות

-משמש רק עבור סיווג בינארי .בנוי כפונקציית .Sפלט של הסתברות.

בהינתן משקל – האם האדם שמן או לא שמן?

בוחרים הסתברות (נקודה על הגרף) ,עבור כל תצפית נחשב את ההסתברות שלה

לעודף משקל ונסדר את הקו בהתאם – כך שבסוף ה train-ייצאו לנו כמה קווים, חשוב לנרמל את הפיצרים של הדאטה! וגם להפוך את הקטגוריאלי

ומהם נבחר את הקו שתופס את הכי הרבה תצפיות והוא יהיה המודל (.)MLE עם .labelEncoderפיצול הדאטא ל trainו .test

הערך הנכון יהיה בטווח שבין הערך החזוי פחות RMSEלבין הערך נמדד עפי ()accuracy ,precision ,recall

החזוי ועוד RMSE

𝒑𝒓𝒆𝒅𝒊𝒄𝒕 value−𝑹𝑴𝑺𝑬≲𝒕𝒓𝒖𝒆 value≲𝒑𝒓𝒆𝒅𝒊𝒄𝒕 value+ 𝑹𝑴𝑺E

אם ה testיותר גדול מה trainזה אומר שהוא חזה מעולה. -

מתי ?overfitכאשר המודל התאים את עצמו ל trainוכאשר הוא יקבל dataחדש הוא יטעה. -

אם יש לי ב train accuracy 87וב - 50 testהוא אומן לא טוב ,לא חזה את התוצאות טוב.

– Regression Decision Treeמנבא משתנה רציף regression, supervised

Clustering: group observations into “meaningful” groups

Classification: predict class from observations

Regression (prediction): predict value from observations

מודל מסוג - regressionעץ החלטה שנועד לחזות ערך מספרי רציף.

למשל ,אנחנו רוצים לבנת מודל באמצעות שילוב של פיצ'רים כדי לחזות את הערך של הבית.

נשתמש בעץ החלטה ,נחשב ידנית,

נבדוק – RMSEאם ה testו trainדומים – זה טוב( .במקום דיוק)precision, recall ,

אם זה קרוב ל ( overfitting = 0כמו לקבל 100%ב trainingבעץ)

– RMSEמדד למידת הפזורות של שגיאות החיזוי .מדד שבודק את איכותו של ,Regression modelנקבל את סטיית החיזוי (ממוצע ההפרשים בין

העמודות בריבוע ואז שורש התוצאה) .נבצע את אותו החישוב על ה testועל ה .trainingככל שתהיה קירבה בין שני המדדים כך המודל יחשב לטוב

יותר RMSE .קרוב ל 0-יראה על )RMSE = squared=false( .overfitting

– Linear Regressionמנבא משתנה רציף regression, supervised

מודל המתבסס על משוואת הקו הישר .נמצא קו לינארי שמתאר את הקשר בין – Xעמודות הפיצ'רים (משתנה בלתי תלוי) לבין – Yעמודת המטרה

(משתנה נומרי רציף תלוי) .יש עמודת מטרה.

רגרסיה לינארית מנבאת משתנה תלוי מתמשך בהתבסס על ערכים של משתנים בלתי תלויים.

למשל ,בהינתן גודל של דירה אנחנו רוצים לחשב את המחיר שלה.

מציירים קו לינארי רנדומלי בהתבסס על כל הנקודות בגרף,

כל פעם מתקנים את הזווית של הגרף כדי שיהיה כמה שיותר קרוב לכל הנקודות,

עד לקבלת גרף אשר יהיה קרוב לכל הנקודות יחסית ויהיה לו מספר errorקטן ביותר (סכום

סטיות מהקו קטן) .גוזרים את הפונקציה הלינארית עד להגעה למינימום.

פיצ' ר יכול להשפיע על התוצאה של מודל לטובה או לרעה.

למשל פיצ'ר של פשיעה ,יכול להשפיע לרעה על מחיר של דירה ,להוריד אותה( .עפי המקדמים)

אפשר לוותר על הפיצ'ר עם המקדם הכי נמוך .בקושי משפיע על הטרגט.

חשוב לנרמל את המידע .לשמור std & mean

נמדד עפי .RMSEמחלקים את המידע.

מדד ה( Coefficient-מקדם ה:)X-

ככל שערכו גדול יותר כך הוא משפיע יותר על ה.Target •

כיוונו (שלילי/חיובי) מראה את השפעתו על ה.Target- •

נשווה את ה RMSEבין ה treeל linear regressionלמי מבניהם שערכי הRMSE-

קטנים יותר בטסט = מודל טוב יותר (מדד לכמה המודל מדויק).

unsupervised, clustering – K Means Cluster

יצירת תובנות ממידע ללא ,labelsנחפש דפוסים מסוימים.

אין עמודת טרגט.

נחלק את המידע לקבוצות שונות של קלאסטרים – כל מי שנמצא

בקלאסטר ספציפי יש להם מכנה משותף .הדמיון בין התצפיות

נקבע לפי מרחקים.

עושים קלאסטרינג כדי לזהות דפוסים "חבואים" ,לזהות פיצרים חשובים,

לסכם את הדאטא ,לזהות אנומליות.outliers ,

נוסחת מרחק בין נקודה לקלאסטר -

ניתן לשלוט רק בכמות הקלאסטרים ( ,)Kלא בפילוח התצפיות.

הלולאה:

חישוב מספר נתון של סנטרוידים ,הגרלת נקודות המרכז שלהם ו שיוך כל נקודה אחרת בגרף לסטנרויד שיותר קרוב אליו עפי נוסחת מרחק .לאחר

שיוך הנקודות והמעגל ,חישוב הממוצע של כל סטנרויד ושיוך ועדכון נקודות המרכז מחדש.

יכול להיות מצב שלאחר שיוך נקודות המרכז ,נקודות מסוימות יהיו משוייכות לקלאסטר אחר ויעברו אליו בהתאם.

הלופ יגמר כאשר לא יהיו עוד מעברים של נקודות בין קלאסטרים ( .יכול להיות שזה לעולם לא יגמר ,לכן ניתן להגביל מספר איטרציות).

חשוב לנרמל את המידע ,כדי שלא יקרה מצב שמספרים גבוהים מושכים את הנקודות אליהם ,או שהקלאסטרים יהיו מושפעים מ( .outliersאי

אפשר להשוות בין דולר למס' שנים) .כשבוחרים את , Kלהתבסס על דברים יודעים ,מספר מינים ,מספר זאנרים בסרטים וכו']] .דוגמה של

פרופילים בפייסבוק -וכל קלאסטר עם מילות מפתח שונות (מוזיקה ,כדורסל[..

clustering, unsupervised – Hierarchical Clustering

K-Means VS Hierrachical קלאסטר טוב – קלאסטר עם תצפיות דומות.

Kmeansדורש לציין מספר קלאסטרים חשוב לנרמל ,אין עמודת טרגט.

Hirarchicalבונה היררכיה מלמטה למעלה כאשר

בהתחלה כל תצפית היא קלאסטר עד שהוא מקבץ בהתחלה של התהליך כל נקודה בפני עצמה היא קלאסטר.

תצפיות דומות ביחד.לא דורש לציין מספר לאחר מכן יש איחוד של שני תצפיות קרובות וככה בלופ ,עד

קלאסטרים שמגיעים לקלאסטר אחד .זמן ריצה ארוך .ה K-לא ידוע מראש.

כמו כן KMEANSמספק פתרון יחיד (עבור כל ריצה

צריך לספק Kשונה) .ניתן לראות התפלגות של HIER שיטות חישוב מרחק בין קבוצות:

– WARDסכום מרחק ריבועי מינימלי בין קלאסטרים– Maximum/complete .

מרחק מקסימלי בין הנקודות בין זוג קלאסטרים.

- Averageחישוב ממוצע המרחקים בין שני הנקודות האפשריות בזוג קלאסטרים – Single .חישוב נקודות הקרובות יותר בין זוג קלאסטרים.

)נעביר קו אופקי בחצי של הקו האנכי הכי ארוך וככה נדע כמה קלאסטרים יש (הקו מייצג את השונות הכי גבוהה

[] אפשר לנסות שוב עם טרשהולד אחר לתוצאות אחרות.) אין רנדומליות (המודל היחיד,RANDOM SEED אין

.)) באמצע הקו האנכי הארוך ביותר (שונות גדולהthreshold( האופטימלי? נעביר קו אופקיK איך נמצא את

. בניית הקלאסטרים,דנדוגרם – מציג באופן ויזואלי את שלבי האיחוד של התצפיות

) מאפיין כזה לא תורם, ID חלק הם כמו,( לא כל פיצר מעניין אותנו וננרמל אותו

. להפיק לקחים ומסקנות מכל קלאסטר. האצה וכדומה,ניתן לייצג את המודל עפי כוח סוס

bins=[147 ,65 ,25 ,1-] =

labels = ["young", "mid", "old"] – מרחק אוקלידי

df['age_range'] = pd.cut(df['age'], bins=bins,

labels=labels) [Discritization]

:שאר פקודות חשובות

Box Plot: plt.boxplot(df.price, showmeans=True)

Multivariate boxplot: df.boxplot(column=['price'], by='color', grid-False)

dfNA = dfNA[dfNA['housing_type'].isna()]

df.club_member.value_counts().plot(kind="bar", title="Club member", xlabel="Value", ylabel="Count", color="navy")

plt.hist(df.age, bins=42, color='b', edgecolor='black', linewidth=1.2)

df5 = df.loc[(df['age'] >= 38) & (df['age'] <= 50)]

)(df_cut_family_status_bars = df.groupby(['status', 'sex'])[['sex']].count

print(df.loc[(df['income'] > 16000) & (df['state_of_res'] == "Washington")]['income'].min())

df6 = df6.loc[:, ((df.dtypes == np.int64) | (df.dtypes == np.float64))]

df10 = df.groupby(['sex', 'housing_type']).size().sort_values(ascending=False)

plt.hist(df.age, bins=42, color='b', edgecolor='black', linewidth=1.2)

)(below_median_count = df["room_price"][df["room_price"] <= room_price_median].count

temp_df = df[(df['total_expenditure'] >= 0)]

new_df = new_df[new_df['passtime'] != np.nan]

:מודלים

print("Precision:", metrics.precision_score(y_train, y_pred_train))

reg.intercept_) #free constant (linear regression)

print("all coefficients are: ", np.column_stack((X_train_z.columns, reg2.coef_)))

dfNA = df[['housing_type', 'recent_move', num_vehicles']] kmeans.cluster_centers | X_train_z = stats.zscore(y_train)

dfNA = dfNA[dfNA['housing_type'].isna()]

df['price'].quantile(q=[0,0.25, 0.5, 0.75, 1])

print(dfNA.isna().sum()) – סוכם מכל עמודה

IQR= Q3-Q1..... Q1 = df[‘age].quantile(0.25)

plt.hist(df[df['is_employed'].isna()].age)-נגלה ערכים חסרים

df['is_employed'].replace(to_replace=np.nan, value="retired") - נחליף אותם בעמודה חדשה

You might also like

- Data Science - סיכום כוללDocument116 pagesData Science - סיכום כוללDanielNo ratings yet

- תורת הגרפים סיכום משפטים והגדרותDocument11 pagesתורת הגרפים סיכום משפטים והגדרותjust ZenabNo ratings yet

- פתרון לדוגמא תרגיל 7Document8 pagesפתרון לדוגמא תרגיל 7hkabesaNo ratings yet

- חקר ביצועים - דף הנוסחאות המעודכן למבחןDocument4 pagesחקר ביצועים - דף הנוסחאות המעודכן למבחןקארין סויסהNo ratings yet

- Chapter13 JavaDocument34 pagesChapter13 JavaSUKABLATNo ratings yet

- מבחן TDocument23 pagesמבחן Tapi-19729700No ratings yet

- דףעזרלתלמיד שפתפייתוןDocument6 pagesדףעזרלתלמיד שפתפייתוןloox_dgNo ratings yet

- הסתברות וסטטיסטיקה - שיעור 8 - 131207Document11 pagesהסתברות וסטטיסטיקה - שיעור 8 - 131207api-3738386100% (2)

- סיכום ממג למתקדמים 2006Document31 pagesסיכום ממג למתקדמים 2006Elior ArielNo ratings yet

- UntitledDocument5 pagesUntitledGabi Lemishov KiryuNo ratings yet

- דף נוסחאותDocument4 pagesדף נוסחאותgal.naor93No ratings yet

- סטטיסטיקה למהנדסים גירסה 2017Document3 pagesסטטיסטיקה למהנדסים גירסה 2017mefak46208No ratings yet

- סיכום שיטותDocument5 pagesסיכום שיטותNeria CarmelNo ratings yet

- ניתוחי שונות ומשתני דמהDocument6 pagesניתוחי שונות ומשתני דמהnoa valansiNo ratings yet

- שיעור 6 - מערכים ומטריצותDocument46 pagesשיעור 6 - מערכים ומטריצותrylsm947No ratings yet

- קודיםRDocument23 pagesקודיםRnoa valansiNo ratings yet

- Lecture1 First StepsDocument45 pagesLecture1 First StepsAbed ulkareem QasimNo ratings yet

- Relational AlgebraDocument35 pagesRelational AlgebraOmerNo ratings yet

- סטטיסטיקה נוסחאות1Document10 pagesסטטיסטיקה נוסחאות1Oz Efraim EliavNo ratings yet

- סטטיסטיקה - סיכום סמסטר א'Document3 pagesסטטיסטיקה - סיכום סמסטר א'Gabi Lemishov KiryuNo ratings yet

- תרגיל 3 חדשDocument2 pagesתרגיל 3 חדשsivanNo ratings yet

- 2019 מועדאDocument8 pages2019 מועדאtayger110807No ratings yet

- Simulated AnnealingDocument10 pagesSimulated Annealingאליהו זילברברנדNo ratings yet

- דף למבחןDocument9 pagesדף למבחןtcasd sdsdsNo ratings yet

- עקרונות כלליים להצגת לוחות ממצאיםDocument8 pagesעקרונות כלליים להצגת לוחות ממצאיםNofar2498 buNo ratings yet

- הרצאה 8 מקוצרת חורף תשפד - מחרוזות ומטריצותDocument40 pagesהרצאה 8 מקוצרת חורף תשפד - מחרוזות ומטריצותMoriel GolbaharNo ratings yet

- יעילוות שאלות ותשובותDocument76 pagesיעילוות שאלות ותשובותTomerKoznichkiNo ratings yet

- Lec 2Document34 pagesLec 2Александр РатнерNo ratings yet

- תרגיל בית 5Document2 pagesתרגיל בית 5Tarik BakirNo ratings yet

- מדח - הרצאה 1Document6 pagesמדח - הרצאה 1Noam ShemlaNo ratings yet

- 1נוסחאותDocument8 pages1נוסחאותDanielNo ratings yet

- סיכום לרקורסיותDocument2 pagesסיכום לרקורסיותfaten halabyNo ratings yet

- ��יישומי מחשב סמסטר א�Document7 pages��יישומי מחשב סמסטר א�DanielNo ratings yet

- דפי עזר בc#Document11 pagesדפי עזר בc#tomerdavid335No ratings yet

- עבודת מטלבDocument6 pagesעבודת מטלבelad kotlovskiNo ratings yet

- השוואה בין ניתוח שונות דו כיווני - 2 על 3 - לבין רגרסיה ב- rDocument13 pagesהשוואה בין ניתוח שונות דו כיווני - 2 על 3 - לבין רגרסיה ב- ryossefkv4050No ratings yet

- סטטיסטיקה תרגול 1Document41 pagesסטטיסטיקה תרגול 1api-19729700No ratings yet

- ביואינפורמטיקהDocument10 pagesביואינפורמטיקהddNo ratings yet

- הסתברות וסטטיסטיקה - שיעור 9 - 201207Document11 pagesהסתברות וסטטיסטיקה - שיעור 9 - 201207api-3738386No ratings yet

- שבוע 3 - עוד מבני נתוניםDocument54 pagesשבוע 3 - עוד מבני נתוניםmayah sabarNo ratings yet

- EX3 2011 AfekaDocument5 pagesEX3 2011 Afekazho2010No ratings yet

- אוריינות סיכום מבחןDocument31 pagesאוריינות סיכום מבחןitaiatiasNo ratings yet

- עבודה פיתוןDocument3 pagesעבודה פיתוןRabea EgbariaNo ratings yet

- מסמך ללא שםDocument7 pagesמסמך ללא שםnunuarbibNo ratings yet

- למידת מכונה - מחברת הרצאותDocument119 pagesלמידת מכונה - מחברת הרצאותyoloort123freeNo ratings yet

- DS SyllabusDocument5 pagesDS Syllabusחיים הרפזNo ratings yet

- C 210914Document28 pagesC 210914Uri WeltmannNo ratings yet

- JWork21 Library FunctionsגעDocument5 pagesJWork21 Library Functionsגעor.bloomsteinNo ratings yet

- P1 N2ouiselDocument18 pagesP1 N2ouiselbarboor03No ratings yet

- Machine Learning Gadi Herman Chapter 3Document5 pagesMachine Learning Gadi Herman Chapter 3haimamosNo ratings yet

- דאסט - גרפיםDocument37 pagesדאסט - גרפיםSidó AcrãdéNo ratings yet

- 2016 מועד אDocument4 pages2016 מועד אAnonimusNo ratings yet

- כל תקצירי השיעורים של דומצבסקי באריזה אחתDocument139 pagesכל תקצירי השיעורים של דומצבסקי באריזה אחתeitanrNo ratings yet

- Sol Sys211bDocument10 pagesSol Sys211bShiri NeisserNo ratings yet

- פקודות unix יוניקסDocument16 pagesפקודות unix יוניקסMishel YonaNo ratings yet

- שבוע 4 - בוליאנים ויצירת רשימותDocument32 pagesשבוע 4 - בוליאנים ויצירת רשימותmayah sabarNo ratings yet

- HW 1Document2 pagesHW 1Nadav LevyNo ratings yet

- תרגיל בית מספר 8 - מצביעיםDocument8 pagesתרגיל בית מספר 8 - מצביעיםdfghhjtrdNo ratings yet

- פרק 7 - מערכיםDocument101 pagesפרק 7 - מערכיםMor CohenNo ratings yet

- Lacture2 SystemDocument27 pagesLacture2 SystemOrenEliezerNo ratings yet

- Data Science סיכום שיעורDocument75 pagesData Science סיכום שיעורDanielNo ratings yet

- 1נוסחאותDocument8 pages1נוסחאותDanielNo ratings yet

- נוסחאות אקסלDocument3 pagesנוסחאות אקסלDanielNo ratings yet

- סיכום עם החסרותDocument9 pagesסיכום עם החסרותDanielNo ratings yet